نقش GPUها در یادگیری عمیق

محاسبات GPU صنایع مختلفی را متحول کرده و پیشرفتهای یادگیری عمیق کاربردی را در وسایل نقلیه خودران، رباتیک و زیستشناسی مولکولی ممکن ساخته است. قابلیتهای پردازش موازی پرسرعتی که این ماشینها ارائه میدهند، محاسبات ضرب ماتریسی مورد نیاز برای پردازش و تبدیل حجم عظیمی از دادهها را برای آموزش و استنتاج (پیشبینی) مدلهای یادگیری عمیق که شامل لایههایی از گرههای بههمپیوسته (شبکههای عصبی) هستند، تسریع میکند.

آموزش این شبکههای عصبی و انجام استنتاج بهصورت سریعتر و ارزانتر، اولویتی مهم در تحقیق و توسعه هوش مصنوعی است. در زمینه محاسبات GPU، این امر مستلزم درک چگونگی بهینهسازی بهتر عملکرد GPU است.

پیشنیازها

آشنایی با موارد زیر به درک بهتر موضوعات ارائهشده در این مقاله کمک میکند:

• مبانی یادگیری ماشین (ML) و یادگیری عمیق (مثلاً ضرب ماتریس، شبکههای عصبی، پایتون، PyTorch)

• انواع داده (INT، FP و غیره)

• معماریهای اخیر GPUهای NVIDIA: بلکول (اعلامشده اما هنوز در دسترس نیست)، هاپر (۲۰۲۲)، آمپر (۲۰۲۰)

• CUDA و سلسلهمراتب حافظه GPU

مقدمهای بر بهینهسازی GPU

هدف این مقاله ارائه بینشی به خوانندگان برای بهبود تجربه محاسباتی آنها است. افرادی که علاقهمند به بهینهسازی عملکرد GPU هستند، توصیه میشود با ویژگیهای جدیدترین معماریهای GPU آشنا شوند، چشمانداز زبانهای برنامهنویسی GPU را درک کنند و با ابزارهای نظارت بر عملکرد مانند NVIDIA Nsight و SMI آشنا شوند. آزمایش، ارزیابی و تکرار بهینهسازیهای GPU برای دستیابی به بهرهوری بهتر از سختافزار بسیار مهم است.

بهرهگیری از ویژگیهای سختافزاری GPUهای NVIDIA

دانش دقیق درباره معماریهای GPU میتواند شهود شما را در برنامهنویسی پردازندههای موازی عظیم بهبود بخشد. در نسلهای متوالی GPU، NVIDIA تعدادی ویژگی سختافزاری تخصصی را برای افزایش قابلیتهای پردازش موازی خود معرفی کرده است.

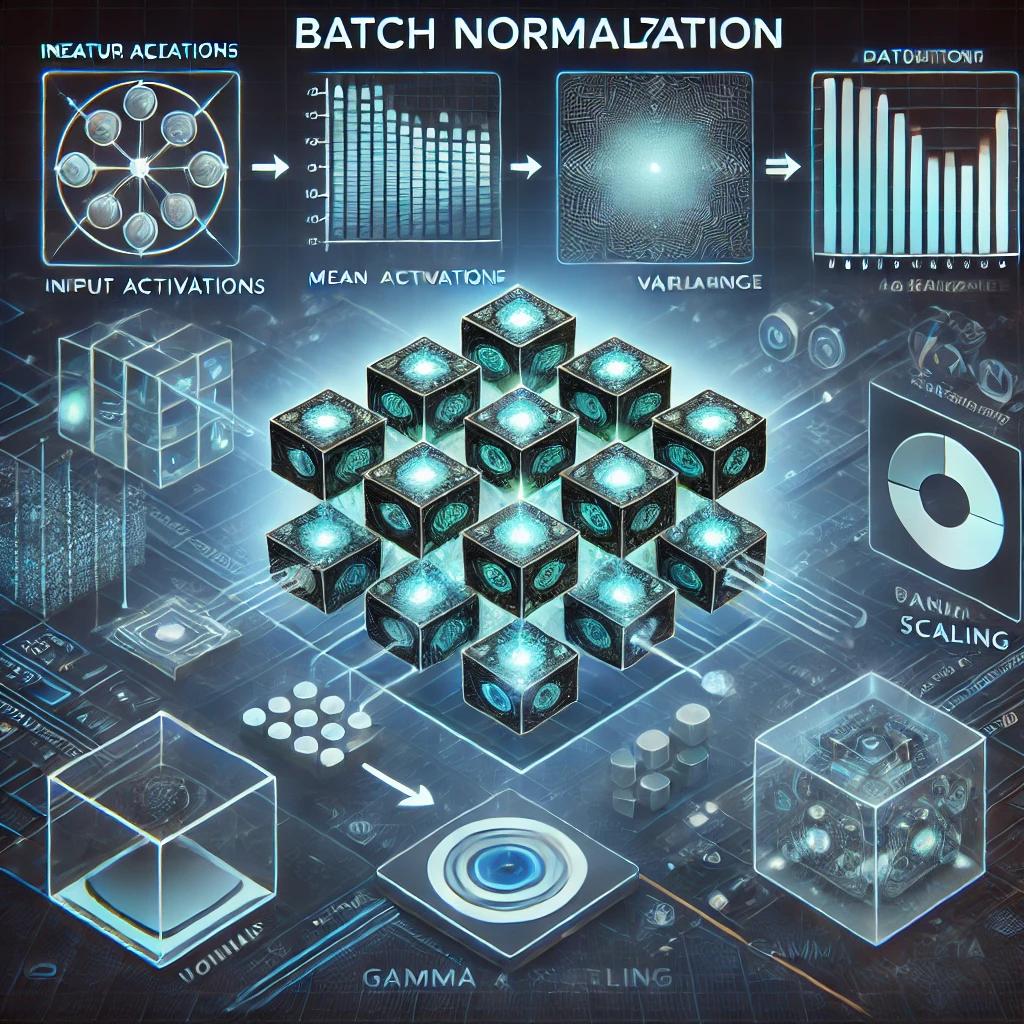

هستههای Tensor

بهطور پیشفرض، بسیاری از کتابخانههای یادگیری عمیق (مثلاً PyTorch) از دقت تکی (FP32) برای آموزش استفاده میکنند. بااینحال، دقت تکی همیشه برای دستیابی به دقت بهینه ضروری نیست. دقت پایینتر به حافظه کمتری نیاز دارد و سرعت دسترسی به دادهها را افزایش میدهد (پهنای باند حافظه).

هستههای Tensor امکان محاسبات با دقت مختلط را فراهم میکنند، جایی که از FP32 فقط در مواقع ضروری استفاده شده و کمترین نوع دادهای که دقت را به خطر نمیاندازد، بهکار گرفته میشود. تاکنون پنج نسل از هستههای Tensor معرفی شده است که نسل چهارم آن در معماری هاپر و نسل پنجم آن در معماری بلکول قرار دارد.

|

نسل هسته Tensor

|

نوع داده معرفیشده

|

|

ولت (نسل اول)

|

FP16، FP32

|

|

آمپر (نسل سوم)

|

Sparsity، INT8، INT4، FP64، BF16، TF32

|

|

هاپر (نسل چهارم)

|

FP8

|

|

بلکول (نسل پنجم)

|

FP4

|

موتور Transformer

موتور Transformer کتابخانهای است که امکان استفاده از دقت FP8 را در GPUهای هاپر فراهم میکند. معرفی دقت FP8 در این GPUها، عملکرد را نسبت به FP16 بهبود داد، بدون اینکه دقت را کاهش دهد. نسل دوم این موتور در معماری بلکول قرار دارد و امکان پردازش با دقت FP4 را فراهم میکند.

شتابدهنده حافظه Tensor

شتابدهنده حافظه Tensor (TMA) امکان انتقال غیرهمزمان دادهها بین حافظه جهانی و اشتراکی GPU را فراهم میکند. پیش از معرفی TMA، چندین رشته (thread) و وارپ (warp) برای کپی دادهها با هم کار میکردند. در مقابل، با TMA، تنها یک رشته در بلاک رشتهای میتواند یک دستور TMA را برای مدیریت غیرهمزمان عملیات کپی صادر کند.

GPUها قابل برنامهریزی هستند

حال به این نکته توجه کنید: آیا طراحی سختافزار بر زبان CUDA تأثیر میگذارد؟ یا زبان CUDA طراحی سختافزار را شکل میدهد؟ هر دو مورد صحیح است. این رابطه میان سختافزار و نرمافزار در سخنرانی GTC ۲۰۲۲ تحت عنوان «چگونه برنامهنویسی CUDA کار میکند» بهخوبی توضیح داده شده است، جایی که استیون جونز توضیح میدهد که زبان CUDA تکامل یافته است تا فیزیک سختافزار را قابل برنامهنویسیتر کند.

CUDA

CUDA (Compute Unified Device Architecture) یک پلتفرم محاسبات موازی است که برای پیکربندی GPUها طراحی شده است. CUDA از زبانهای برنامهنویسی مختلفی از جمله C، C++، Fortran و Python پشتیبانی میکند.

کتابخانههای CUDA

تعداد زیادی از کتابخانهها بر پایه CUDA ساخته شدهاند تا قابلیتهای آن را گسترش دهند. برخی از کتابخانههای قابل توجه شامل موارد زیر هستند:

• cuBLAS: یک کتابخانهی جبر خطی پایه (BLAS) با شتاب GPU که قادر به تسریع ضرب ماتریس در دقتهای پایین و مختلط است.

• cuDNN (CUDA Deep Neural Network): کتابخانهای که پیادهسازیهای عملیات متداول در برنامههای شبکههای عصبی عمیق (DNN) مانند کانولوشن، توجه (Attention)، ضرب ماتریس، پولینگ، تبدیل تانسور و غیره را فراهم میکند.

• CUTLASS (CUDA Templates for Linear Algebra Subroutines): کتابخانهای که از محاسبات دقت مختلط با عملیات بهینهشده برای انواع دادههای مختلف، از جمله اعداد ممیز شناور (FP16 تا FP64)، اعداد صحیح (۴/۸ بیتی) و دادههای باینری (۱ بیتی) پشتیبانی میکند. این کتابخانه از هستههای Tensor انویدیا برای ضرب ماتریس با توان عملیاتی بالا استفاده میکند.

• CuTe (CUDA Templates): یک کتابخانه C++ فقط شامل هدر که الگوهای Layout و Tensor را ارائه میدهد. این انتزاعات اطلاعات ضروری درباره دادهها مانند نوع، شکل، مکان حافظه و سازماندهی را دربر میگیرند و همچنین عملیات پیچیدهی اندیسگذاری را امکانپذیر میکنند.

Triton

Triton یک زبان مبتنی بر پایتون و کامپایلر برای برنامهنویسی موازی است. فیل تیلت، خالق Triton، در این ویدیو توضیح میدهد که این زبان برای رفع محدودیتهای برنامهنویسی GPU در CUDA و زبانهای دامنهمحور (DSL) موجود طراحی شده است.

با اینکه CUDA بسیار قدرتمند است، اما برای محققان و متخصصانی که تجربهی تخصصی در برنامهنویسی GPU ندارند، اغلب بیش از حد پیچیده است. این پیچیدگی نهتنها ارتباط بین متخصصان GPU و پژوهشگران یادگیری ماشین را دشوار میکند، بلکه فرایند تکرار سریع را که برای توسعه در حوزههای پرمصرف محاسباتی ضروری است، کند میسازد.

علاوه بر این، DSLهای موجود محدودیتهایی دارند، زیرا از ساختارهای داده سفارشی و کنترل بر استراتژیهای موازیسازی و تخصیص منابع پشتیبانی نمیکنند.

Triton این مشکل را حل کرده و تعادلی ایجاد میکند که به کاربران اجازه میدهد تانسورها را در حافظه SRAM تعریف و مدیریت کنند و آنها را با استفاده از عملگرهایی مشابه PyTorch تغییر دهند، درحالیکه همچنان انعطافپذیری لازم برای پیادهسازی استراتژیهای سفارشی موازیسازی و مدیریت منابع را فراهم میکند. Triton به دموکراتیزه کردن برنامهنویسی GPU کمک میکند، زیرا امکان نوشتن کدهای کارآمد GPU را بدون نیاز به تجربهی گسترده در CUDA فراهم میسازد.

بهرهگیری از سلسلهمراتب حافظه

GPUها انواع مختلفی از حافظه را با اندازهها و سرعتهای متفاوت دارند. رابطهی معکوس بین اندازه حافظه و سرعت، اساس سلسلهمراتب حافظهی GPU را تشکیل میدهد.

تخصیص راهبردی متغیرها به انواع مختلف حافظه در CUDA به توسعهدهندگان کنترل بیشتری بر عملکرد برنامههایشان میدهد. نوع حافظهای که برای متغیر تعیین میشود، دامنهی آن را مشخص میکند (مثلاً متغیر فقط در یک رشته قابل دسترسی باشد یا بین بلاکهای رشتهای به اشتراک گذاشته شود) و همچنین سرعت دسترسی به آن را تعیین میکند.

متغیرهایی که در حافظههای پرسرعتی مانند رجیسترها یا حافظه اشتراکی ذخیره میشوند، سریعتر از متغیرهایی که در حافظههای کندتری مانند حافظه جهانی قرار دارند، بازیابی میشوند.

FlashAttention

نمونهای از یک الگوریتم آگاه از سختافزار است که از سلسلهمراتب حافظه بهره میبرد.

اصلاً عملکرد GPU به چه معناست؟

ارزیابی عملکرد در محاسبات مبتنی بر GPU به مورد استفادهی موردنظر بستگی دارد. با این حال، معیارهای کلیدی برای سنجش کارایی کلی شامل زمان تأخیر (Latency) و توان عملیاتی (Throughput) هستند.

• زمان تأخیر به فاصلهی زمانی بین درخواست و پاسخ اشاره دارد. در زمینه پردازندههای موازی مانند GPU، درخواست زمانی است که GPU یک فرمان پردازشی دریافت میکند و پاسخ زمانی است که پردازش به پایان رسیده و نتیجه بازگردانده میشود.

• توان عملیاتی تعداد واحدهایی را که GPU در هر ثانیه پردازش میکند، نشان میدهد. این معیار ظرفیت پردازشی GPU را برای مدیریت چندین وظیفه بهطور همزمان منعکس میکند.

معماران و توسعهدهندگان GPU همواره تلاش میکنند تا زمان تأخیر را کاهش داده و توان عملیاتی را به حداکثر برسانند.

این معیارها معمولاً هنگام بنچمارکگیری از GPUها مورد بررسی قرار میگیرند. بهعنوان مثال، در مطالعهی Benchmarking and Dissecting the Nvidia Hopper GPU Architecture، پردازندههای Hopper با استفاده از آزمایشهای زمان تأخیر و توان عملیاتی برای واحدهای مختلف حافظه، هستههای Tensor، و ویژگیهای جدید برنامهنویسی CUDA که در Hopper معرفی شدهاند (مانند DPX، انتقال دادههای غیرهمزمان، و حافظهی اشتراکی توزیعشده) مورد سنجش قرار گرفتهاند.

از سخنرانی استیون جونز در GTC 2022، «نحوه کار برنامهنویسی CUDA»:

عملیات ممیز شناور در ثانیه (FLOPs) اغلب بهعنوان یک معیار عملکردی مطرح میشود، اما معمولاً عامل محدودکننده اصلی نیستند. GPUها معمولاً از قدرت محاسباتی ممیز شناور فراوانی برخوردارند و در نتیجه، جنبههای دیگر مانند پهنای باند حافظه معمولاً گلوگاههای مهمتری محسوب میشوند.

ابزارهای نظارت بر عملکرد

نظارت بر عملکرد GPU به توسعهدهندگان و مدیران سیستم کمک میکند تا گلوگاههای عملکردی را شناسایی کنند (آیا پردازش محدود به حافظه، تأخیر یا توان محاسباتی است؟)، منابع GPU را بهطور مؤثر تخصیص دهند، از داغ شدن بیش از حد جلوگیری کنند، مصرف انرژی را مدیریت کنند و تصمیمات آگاهانهای در مورد ارتقای سختافزار بگیرند.

انویدیا دو ابزار قدرتمند برای نظارت بر GPU ارائه میدهد: Nsight و SMI.

Nsight از NVIDIA

NVIDIA Nsight Systems یک ابزار تجزیه و تحلیل عملکرد سیستم است که امکان مشاهده الگوریتمهای یک برنامه و شناسایی بخشهایی برای بهینهسازی را فراهم میکند. اطلاعات بیشتر درباره NVIDIA Nsight Compute را میتوان در راهنمای پروفایلگیری کرنل یافت.

رابط مدیریت سیستم NVIDIA (SMI)

NVIDIA System Management Interface (nvidia-smi) یک ابزار خط فرمان است که بر پایهی NVIDIA Management Library ساخته شده و برای مدیریت و نظارت بر دستگاههای GPU استفاده میشود. اطلاعات بیشتر را میتوان در مستندات nvidia-smi پیدا کرد.

مثال خروجی nvidia-smi:

نتیجهگیری

این مقاله به هیچ وجه تمام جنبههای بهینهسازی GPU را پوشش نمیدهد، بلکه تنها مقدمهای بر این موضوع است. توصیه میشود که لینکهای موجود در سراسر مقاله و بخش منابع را بررسی کنید تا درک بهتری از این موضوع پیدا کنید. مقالات بیشتری در آینده منتشر خواهد شد!

Click to rate this post!

[Total: 0 Average: 0]

نظرات کاربران